贝叶斯统计推断概述

未知参数 $\theta$ 的后验分布 $\pi(\theta\mid\pmb x)$ 集中了抽样信息和先验信息中关于 $\theta$ 的所有信息,有关 $\theta$ 的点估计、区间估计和假设检验等统计推断方法都是按照一定方式从后验分布中提取信息的,其提取方法与经典统计推断相比要简单明确得多。

- 基于后验分布的统计推断意味着只考虑已出现的样本观测值,认为未出现的数据与推断无关,这一观点被称为“条件观点”,基于这种观点提出的统计推断方法被称为条件方法,它与我们在经典统计推断中的频率方法之间具有很大的差别。

-

处理多余参数没有理论问题:如果 $\theta=(\theta_1,\theta_2)$,而 $\theta_2$ 为多余参数,考虑将联合先验分布表示为 $\pi(\theta)=\pi(\theta_1\mid\theta_2)\pi(\theta_2)$,从而

$\displaystyle\pi(\theta_1\mid\pmb x)=\int_{\Theta_2}\pi(\theta_1\mid\theta_2,\pmb x)\pi(\theta_2\mid\pmb x){\rm d}\theta_2.$ 注意:如果 $\pi(\theta_1\mid\theta_2,\pmb x)$ 对不同的 $\theta_2$ 变化较大时,则需要考虑进行灵敏度分析。

贝叶斯点估计

基本概念

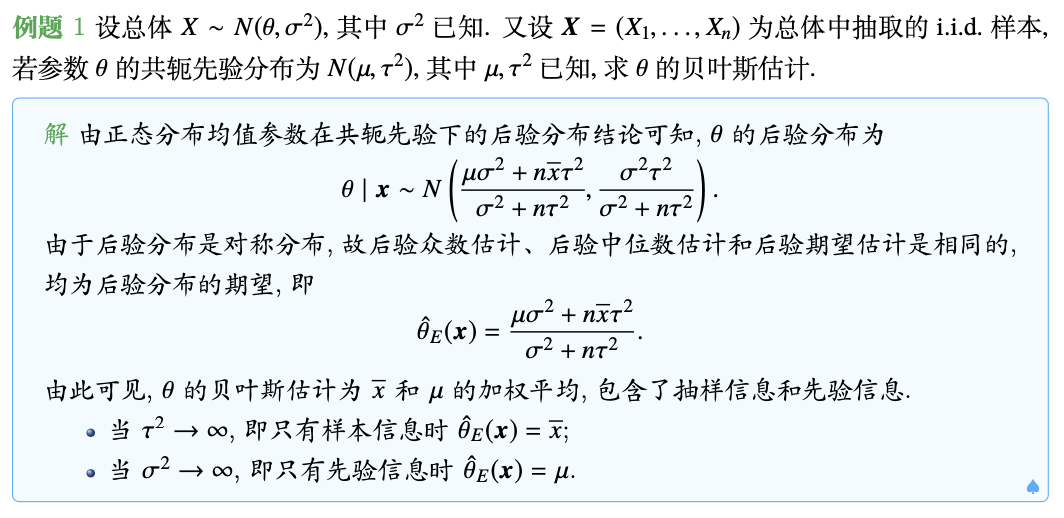

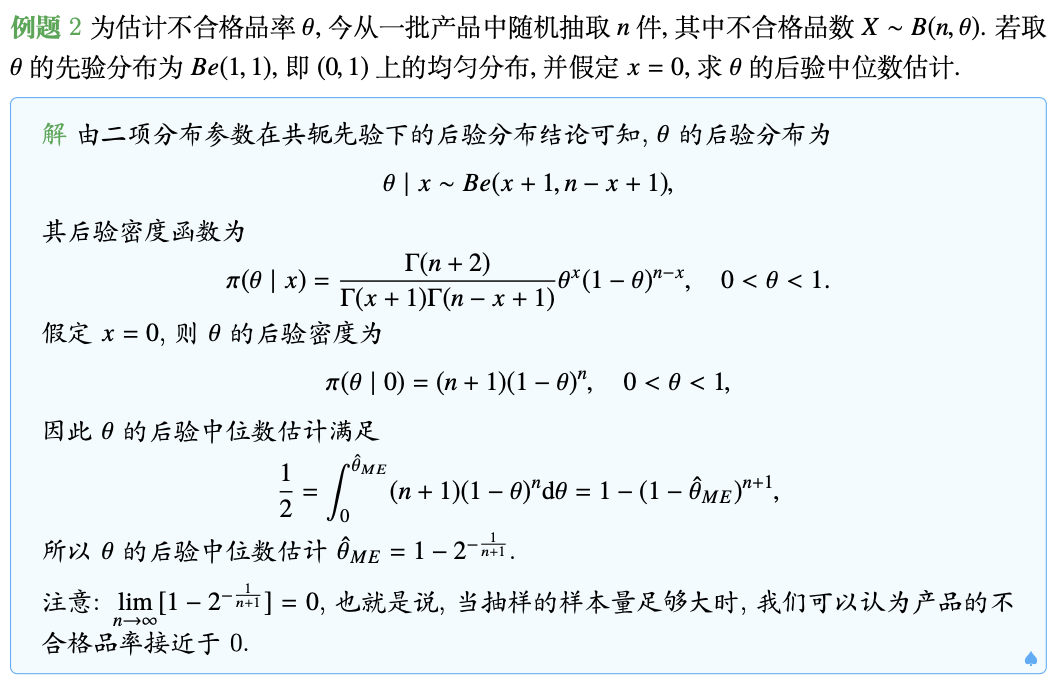

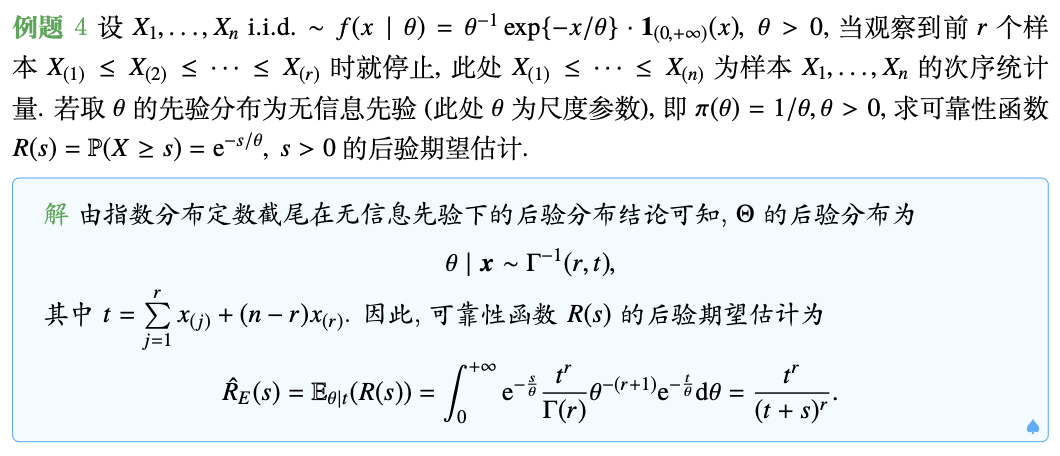

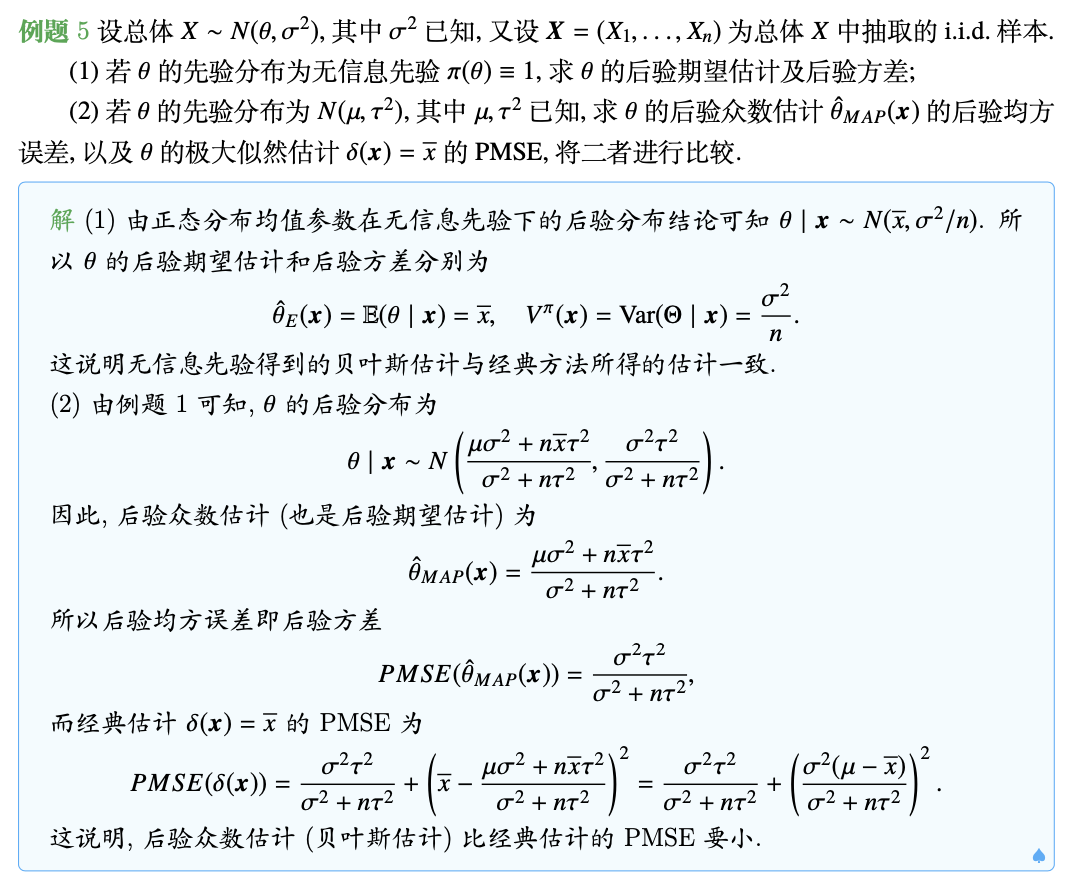

定义(贝叶斯点估计) 用后验密度 $\pi(\theta\mid\pmb x)$ 的均值作为 $\theta$ 的后验点估计,称后验均值

为 $\theta$ 的后验期望估计。

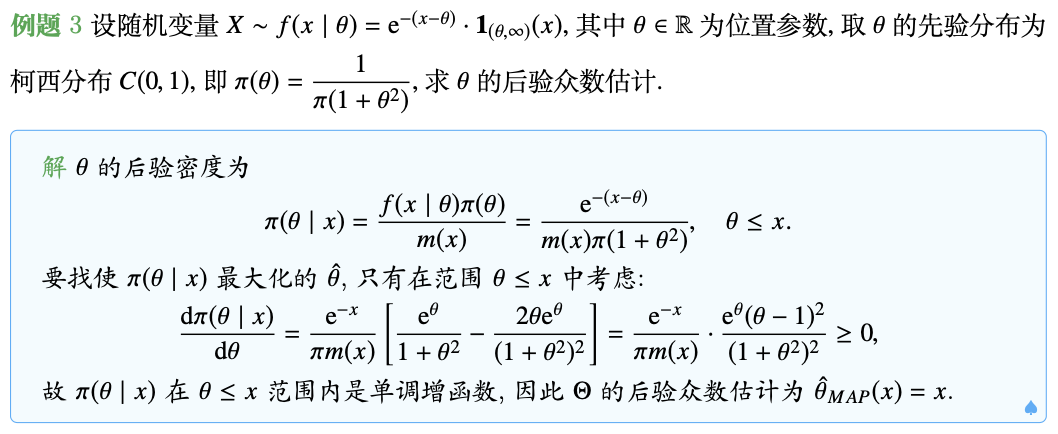

用后验密度 $\pi(\theta\mid\pmb x)$ 的最大值点作为 $\theta$ 的后验点估计,称后验众数

为 $\theta$ 的后验众数估计。

用后验密度 $\pi(\theta\mid\pmb x)$ 的中位数作为 $\theta$ 的后验点估计, 称后验中位数

为 $\theta$ 的后验中位数估计。

贝叶斯点估计的误差

在经典统计方法中衡量一个估计量的优劣是看其均方误差(MSE)的大小,而在贝叶斯统计推断中,对贝叶斯估计 $\delta(\pmb x)$,采用后验均方误差(PMSE),即

来度量估计量的精度,PMSE越小越好。

简记后验均值 $\mu^\pi(x)=\mathbb E(\theta\mid x)$,后验方差 $V^\pi(x)=\text{Var}(\theta\mid x)$,类似于MSE的分解,我们有

特别地,若 $\delta(x)=\mathbb E(\theta\mid x)$ 时,$\delta(x)$ 的PMSE即后验方差,也就是说 $\theta$ 的后验均值估计使其PMSE达到最小。也是因为这个原因,后验期望估计往往在实际应用中作为 $\theta$ 的贝叶斯估计。

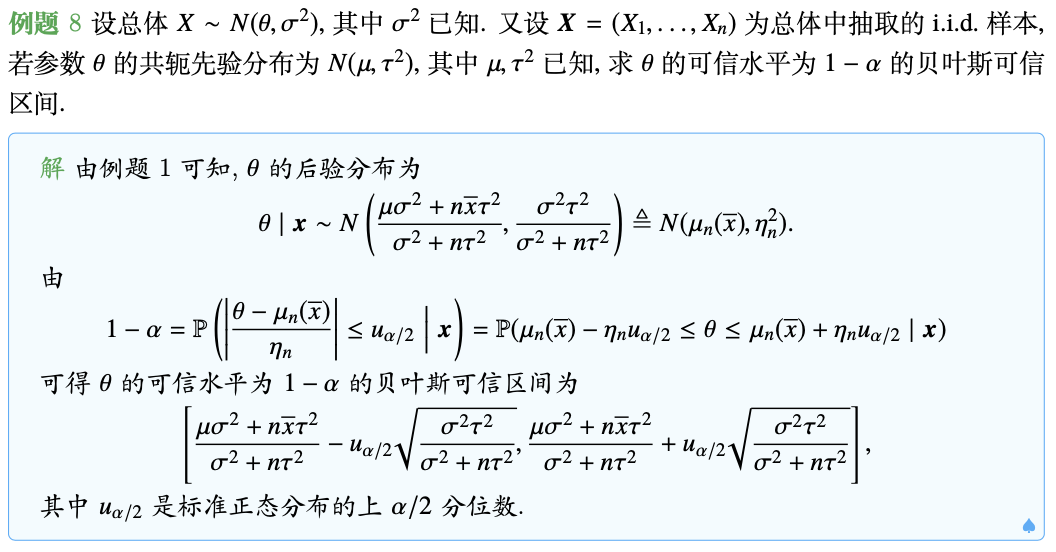

贝叶斯可信区间

在贝叶斯统计推断中,参数的区间估计变得容易得多,因为参数是一个随机变量,我们可以基于后验分布来给出参数的可信区间。

定义(贝叶斯可信区间) 设参数 $\theta$ 的后验分布为 $\pi(\theta\mid\pmb x)$,对给定的样本 $\pmb x$ 和概率 $1-\alpha$($0<\alpha<1$,通常 $\alpha$ 取较小的数),若存在两个统计量 $\hat{\theta}_L(\pmb x)$ 和 $\hat{\theta}_U(\pmb x)$,使得

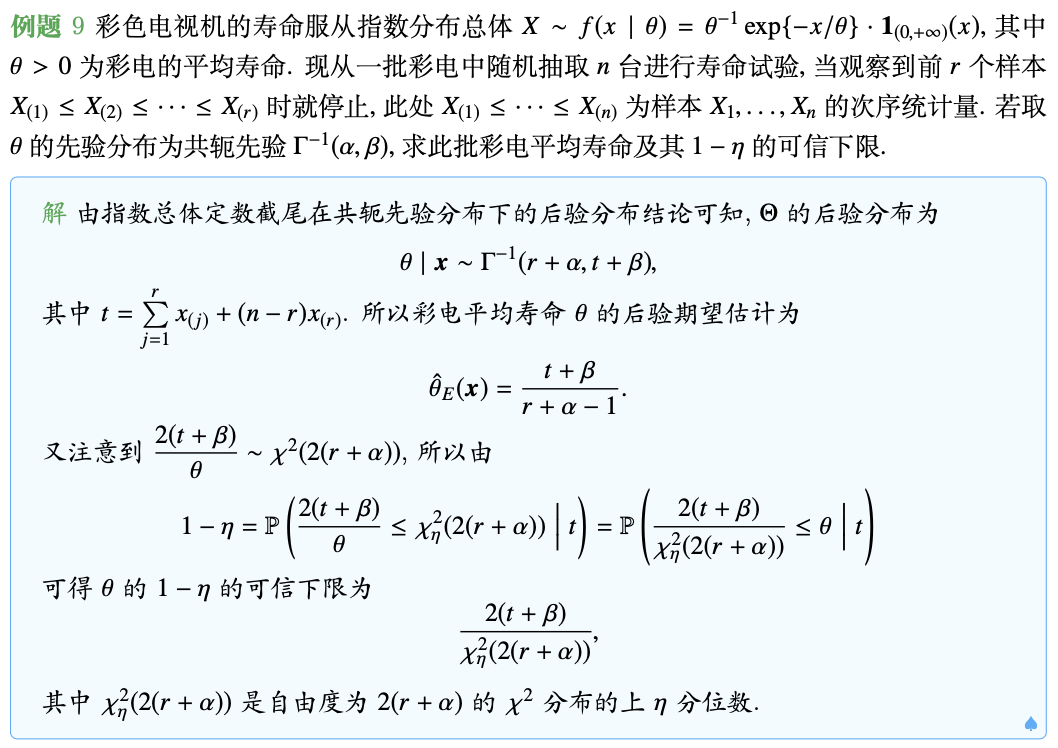

则称 $[\hat{\theta}_L(\pmb x),\hat{\theta}_U(\pmb x)]$ 为 $\theta$ 的可信水平为 $1-\alpha$ 的贝叶斯可信区间,简称为 $\theta$ 的 $1-\alpha$ 可信区间。而满足

的 $\hat{\theta}_L(\pmb x)$ 称为 $\theta$ 的可信水平为 $1-\alpha$ 的贝叶斯可信下限;满足

的 $\hat{\theta}_U(\pmb x)$ 称为 $\theta$ 的可信水平为 $1-\alpha$ 的贝叶斯可信上限。

最大后验密度(HPD)可信区间

衡量一个可信区间的好坏,一看它的可信度 $1-\alpha$,另一个看它的精度,即区间的长度。可信度 $1-\alpha$ 越大,精度越高(即区间越短)越好。寻找最优可信区间的方法是在控制可信度为 $1-\alpha$ 的前提下,找长度最短的区间。

等尾可信区间在实际中常被使用,因为其计算方便,但未必是最好的,最好的可信区间应该是区间长度最短的。因此,只有把具有最大后验密度的点都包含在区间内,而区间外的点后验密度的值都不会超过区间内的点后验密度的值,这样的区间一定是最短的,称为最大后验密度可信区间。

定义(最大后验密度可信集) 设参数 $\theta$ 的后验密度为 $\pi(\theta\mid\pmb x)$,对给定的概率 $1-\alpha$ $(0<\alpha<1)$,集合 $C$ 满足:

- $\mathbb P(\theta\in C\mid\pmb x)=1-\alpha$,

- 对任给的 $\theta_1\in C$ 和 $\theta_2\notin C$,总有 $\pi(\theta_1\mid\pmb x)>\pi(\theta_2\mid\pmb x)$,

则称 $C$ 为 $\theta$ 的可信水平为 $1-\alpha$ 的最大后验密度可信集,简称为 $1-\alpha$ HPD可信集(区间)。

当后验密度为单峰对称时,$1-\alpha$ HPD可信区间易求,它就是等尾的区间。当后验密度虽为单峰,但不对称时,寻求HPD可信区间并不容易,可用计算机进行数值计算。步骤如下:

- 对给定的 $k$ 建立子程序:解方程 $\pi(\theta\mid\pmb x)=k$,解得 $\theta_L(k)$ 和 $\theta_U(k)$,从而组成一个区间

$C(k)=[\theta_L(k),\theta_U(k)]=\{\theta:\pi(\theta\mid\pmb x)\geq k\}.$ - 建立第二个子程序,用来计算概率:

$\displaystyle\mathbb P(\theta\in C(k)\mid\pmb x)=\mathbb P(\theta_L(k)\leq\theta\leq\theta_U(k)\mid\pmb x)=\int_{\theta_L(k)}^{\theta_U(k)}\pi(\theta\mid\pmb x){\rm d}\theta.$ -

对给定的$k$,若 $\mathbb P(\theta\in C(k)\mid\pmb x)\approx 1-\alpha$,则 $C(k)$ 即为所求的HPD可信区间。

若 $\mathbb P(\theta\in C(k)\mid\pmb x)\gg 1-\alpha$,则增大 $k$,再转入(1)与(2);

若 $\mathbb P(\theta\in C(k)\mid\pmb x)\ll 1-\alpha$,则减小 $k$,再转入(1)与(2)。

例如,设 $X_1,\dots,X_n$ 为从柯西分布 $C(\theta,1)$ $(\theta>0)$ 中抽取的随机样本,取先验 $\pi(\theta)\equiv1$ $(\theta>0)$,则后验密度为

对于样本 $\pmb x=(4.0, 5.5, 7.5, 4.5, 3.0)$,采用可信区间的计算方法,有如下程序代码。

HPD = function(f, confidence) {

Cons = integrate(f, 0, Inf, y=0)$value

kmin = 0

kmax = f(5, 0) #由密度函数图像极大值附近取得

inter = 0

while (abs(inter-confidence)>1e-6) {

kmid = (kmin + kmax) / 2

lower = uniroot(f, c(0,5), y=kmid)$root

upper = uniroot(f, c(5,10), y=kmid)$root

inter = integrate(f, lower, upper, y=0)$value / Cons

if (inter < confidence) {kmax = kmid}

else {kmin = kmid}

}

returnValue(c(lower,upper))

}

g = function(theta) {

x = c(4.0, 5.5, 7.5, 4.5, 3.0)

y = 1

for (i in 1:5)

y = y/(1+(x[i]-theta)^2)

return(y)

}

f = function(x, y) {

g(x) - y

}

HPD(f, 0.95)

代码输出3.096689 6.059138,此即 $\theta$ 的可信水平为 95% 的HPD可信区间。

大样本方法

设 $X_1,\dots,X_n$ i.i.d. $\sim f(x\mid\theta)$,$\pi(\theta)$ 为 $\theta$ 的先验分布,则后验分布

在适当条件下可以证明:当 $n$ 充分大时,$\pi_n(\theta\mid\pmb x)$ 近似服从 $N(\mu^\pi(\pmb x), V^\pi(\pmb x))$,其中 $\mu^\pi(\pmb x)$ 和 $V^\pi(\pmb x)$ 分别是后验均值和后验方差。此时,$\theta$ 的可信水平为 $1-\alpha$ 的HPD可信区间为

后记

本文内容参考自中国科学技术大学《贝叶斯分析》(2022Fall)课件。

如对本文内容有任何疑问,请联系 watthu@mail.ustc.edu.cn。